După ce am folosit local, pe NPU, un model Llama 3.1 pe Asus Vivobook S15 Snapdrgon X Elite, am încercat acum o versiune a modelului Distilled DeepSeek R1. Din nou, spre surprinderea mea, a mers și chiar fără probleme.

Ideea e așa: Microsoft a anunțat că a creat o versiune specială a modelului DeepSeek R1, pentru folosirea locală pe PC-uri Copilot+, cu NPU-uri Snapdragon. Cine are un astfel de sistem, poate descărca gratuit modelul, îl pune în Visual Code și poate să începe să îl folosească, cu o performanță chiar bună.

Cum instalezi și folosești local un model DeepSeek R1

Haideți să vă spun cum se face instalarea și folosirea. Prima dată aveți nevoie de editorul Visual Studio Code, varianta de ARM. Mergeți pe site-ul Microsoft, descărcați pachetul și apoi instalați-l.

Îl porniți și apoi dați clic pe Extensions (CTRL+SHIFT+X) și în căsuța de căutare scrieți AI Toolkit for Visual Studio Code.

Din lista afișată alegeți acea versiune care e făcută de Microsoft și apoi apăsați butonul Install. Așteptați puțin până se termină instalarea.

Veți vedea că în interfață (în bara din stânga) a apărut un nou buton: AI Toolkit. Clic pe el și apoi alegeți să încărcați un model. Din Model Catalog, clic pe Model type și bifați Local run w/NPU ca să rămâneți doar cu Deepseek R1 Distilled (NPU Optimized) și descărcați-l ca să îl aveți local.

După ce este descărcat, îl puteți încărcă (Load in playground), moment în care vi se oferă accesul la prompt-ul Deepseek direct în fereastra Playground:

Observați că în partea din dreapta aveți datele inițiale cu care rulați local acest model – puteți să le schimbați după cum credeți de cuviință.

De acum aveți pregătit mediul de lucru ca să îi dați drumul la treabă și să vă jucați local cu Deepseek R1. Întrebați-l ce vreți.

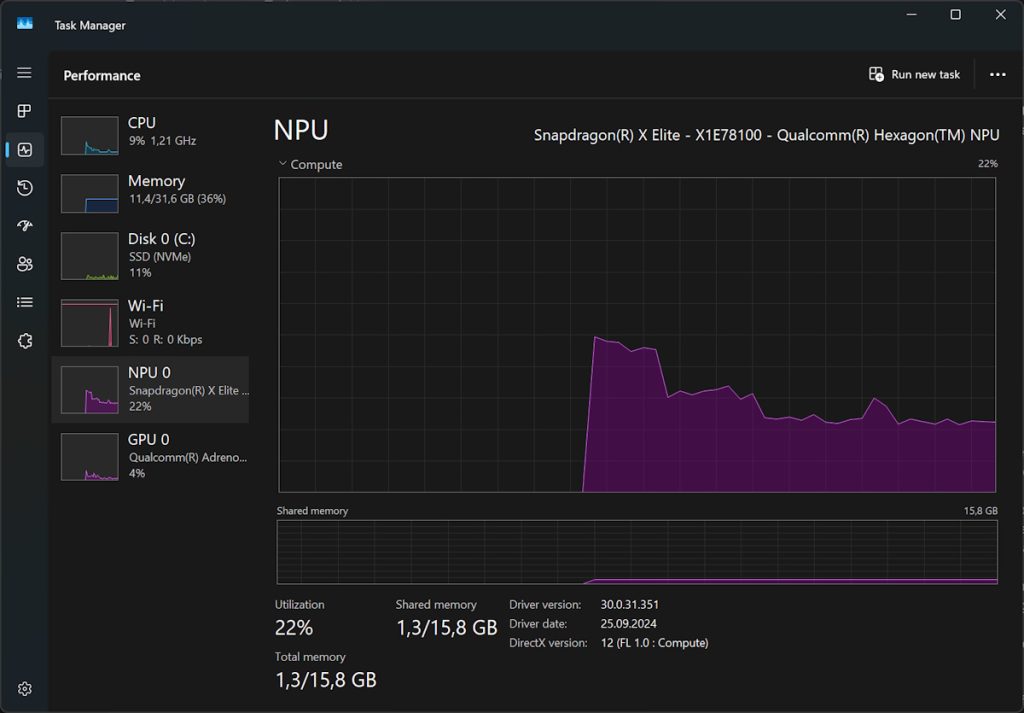

Am petrecut niște timp cu el, pe un laptop ASUS Vivobook S15 (pe baterie, deci nu la performanța maximă!) și s-a descurcat excelent din punct de vedere al încărcării NPU (procesarea nu se face în CPU sau GPU, în schimb e folosit intens procesorul NPU, dedicat operațiilor cu AI) – răspunde în timp real la întrebări (nu l-am configurat să folosească Whisper pentru a putea interpreta comenzile vocale).

Ideea e că merge și e ușor de configurat, iar dacă aveți un PC Copilot+, e o modalitate excelentă să vedeți ce poate face. Nu e greu deloc și mai important, e gratuit și la îndemână. Bag de seamă că Microsoft a făcut o treabă bunicică cu optimizarea acestui LLM pentru folosirea locală pe sisteme Copilot+, unde încărcarea NPU-ului stă la valori acceptabile.

Cam așa de încărcat era NPU-ul când i-am cerut să mă ajute să scriu un skill de Amazon Alexa – observați că CPU-ul și GPU-ul erau la valori foarte mici:

În acest moment e disponibil doar varianta DeepSeek-R1-Distill-Qwen-1.5B (Source), urmând ca în curând în AIToolkit for VSCode să vină și variantele 7B (Source), respectiv 14B (Source).

Sper să vă placă să îl folosiți – dați-i o șansă și vedeți ce iese.